2024年11月26号,由深圳大学法学院主办,深圳大学法律与科技研究院、深圳大学涉外法治研究院承办的“丽湖法治大讲坛”总第一百一十八期暨“涉外法治人才培养高端论坛”第十五期学术讲座于明律楼103报告厅顺利举行。新加坡国立大学法学院副教授,技术、机器人、人工智能与法律研究中心创始人、联席主任辛杰文(Daniel Seng)以“噢!我们所编织的复杂网络:与大语言模型幻觉相关的法律挑战”为题,分享在AI时代背景下,以ChatGPT为代表的人工智能为人类社会带来的一系列现实应用问题挑战和法律思考。法学院院长熊伟、副院长宋旭光莅临现场,讲座由深圳大学法学院助理教授黄炜杰主持。此外,腾讯研究院高级研究员曹建峰、香港中文大学(深圳)前海国际事务研究院副研究员游传满、深圳大学副教授郝晶晶、敖希颖以及助理教授荀晓雅、郭丹阳作为与谈嘉宾,共同参与此次学术交流。本次讲座吸引众多法学专业的本科生及研究生到场聆听。

讲座内容回顾

Daniel Seng教授引用沃尔特·斯科特爵士一首诗的句子:“噢!当我们第一次尝试欺骗时,我们编织了一张多么复杂的谎言之网!”来解释今天讲座题目的灵感来源,并为接下来的演讲做好充分铺垫。

Daniel Seng教授首先解释大语言模型的概念,并对其进行分析,探讨大语言模型是否值得信赖。他指出,大语言模型是一个概率模型,人们主要运用其进行预测自然语言中的单词,而大语言模型之所以如此广泛运用于现代社会中并受到青睐,是因为其使用了额外的两种技术来进行概率计算:第一种是向模型输入大量的文本数据,第二种是使用自我监督和半监督学习来训练模型识别单词以提升预测概率,并由此引入人们运用大语言模型进行分析的场景:检查拼写错误、检查代码、回答问题、生成内容、提供建议、翻译等等,此外,他还提到目前新加坡正在将大语言模型用作协助接听并记录报警电话。

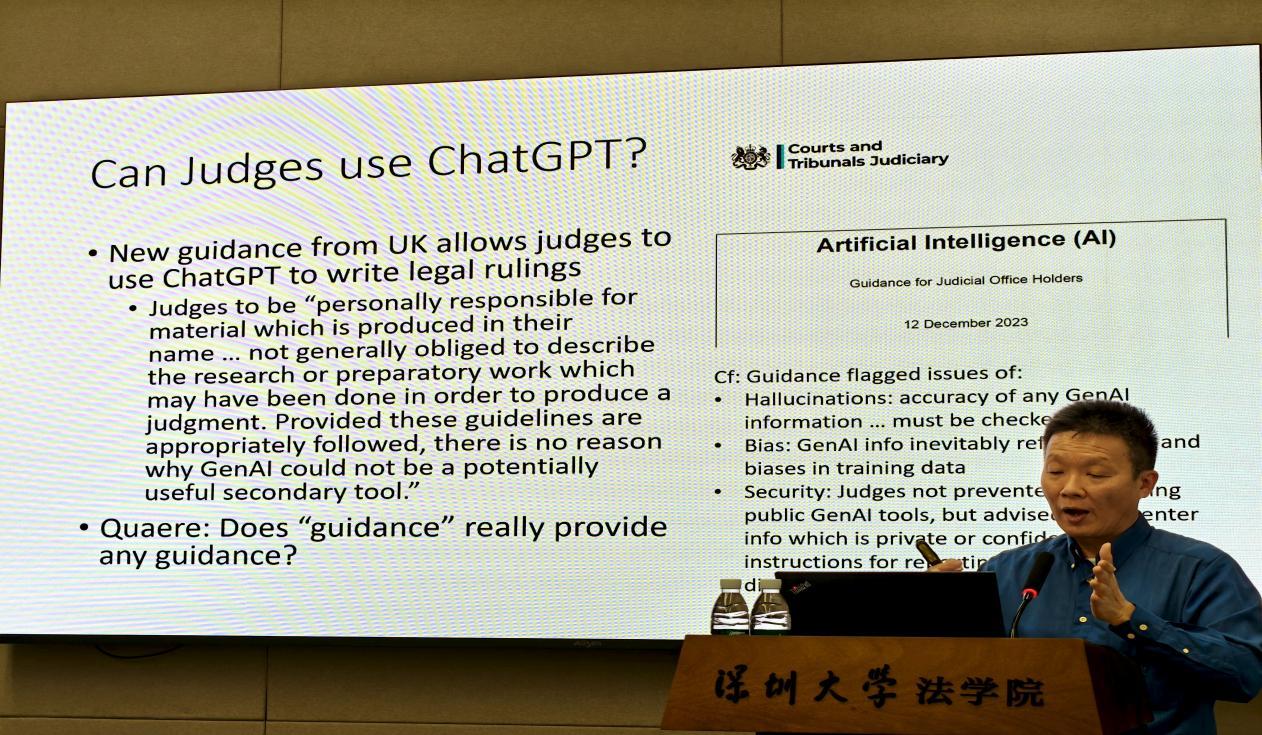

随后,Daniel Seng教授提到大语言模型如何影响到法律专业人士,通过在ChatGPT和新加坡法律人工智能软件“Scott”输入同一案例让其进行专业分析对比,向与会师生展现了两个平台所存在的“幻觉欺骗”现象:它们虚构了引用的案例和虚假的案件编号来混淆视听,而这些错误在未来将会在未来带来严重后果。

此外,Daniel Seng教授还提到一些实例,如律师使用大语言模型准备案件而导致败诉等法律后果,进一步强调了大语言模型在法律决策中的潜在风险和不信任问题。因此,作为法律人,如何正确运用大语言模型并识破其“幻觉欺骗”将是十分重要的课题。

互动交流

与谈环节,曹建峰研究员从技术层面出发,提到当前大语言模型发展速度之迅猛,对包括法律在内的各行各业都带来了冲击,但同时也会是一种机遇和一种新的协作方式,而对于Daniel Seng教授所提到的“幻觉欺骗”,他认为在人工智能辅助的情况下依然需要人为介入的审查把关,由此产生的责任问题也是当前学界需要重点关注的部分。

游传满副研究员则提出,在AI深度融合的大背景下,不同学科的师生在各自的专业领域有了更多值得交流的课题。他还提到关于使用大语言模型产生的责任承担,参考类似谷歌AI免责的形式类型,目前正有延伸的趋势。

敖希颖副教授指出,大语言模型的主要缺陷在于实际上它并不完全理解信息,它更像是一种排列组合的算法,只给出概率最高的结果,由此引发了许多诸如大语言模型如何判断信息对错,或者是它本身并没有能力判断事情真伪,又如何法律限制下使用这些信息的矛盾。此外,她还提到,由于大语言模型的强大和普遍性,人们会将其作为一种快速参考工具并乐于使用它,但是人们并不知道如何去规避潜在的危险,这种矛盾迫使人们不得不在使用的便利性和信息的正确性中找到平衡。

荀晓雅助理教授则指出,目前大语言模型产生诸多问题的原因之一在于人们并不清楚自己的信息输入和大语言模型的信息输出之间的机制,所以人们没有办法从中间进行干预从而防止大语言模型输出假信息。此外,她还提到,大语言模型是当下每个人都会使用的工具,而在法律、医疗等专业领域,对于其准确性和有效性还应当与人的准确率进行对比,才能得出正确结论。

讲座最后,Daniel Seng教授还耐心地回答同学们提出的问题。

结语

本次讲座为我们深入探讨了大语言模型,尤其是ChatGPT等人工智能技术在法律领域应用中带来的挑战与机遇,不仅为法学界提供了关于AI与法律交叉领域的前沿思考,也促使我们重新审视科技进步如何与法律实践深度融合,确保法律决策的公正与精准,具有重要的学术价值和实践意义。